음악을 들려주면 영상이 따라온다: AI 뮤직비디오

📌 핵심 요약

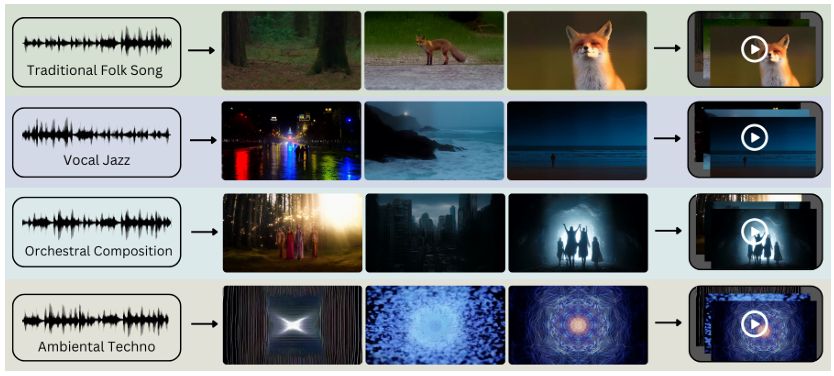

- 무엇을 했나? 음악(가사 유무 무관)을 입력하면 AI로 스토리 → 장면 대본 → 텍스트→비디오 클립을 자동 생성해 최종 뮤직비디오를 만드는 파이프라인 2가지를 제안했어요.

- 두 가지 흐름: (A) CLAP(음악-문장 정렬) → LLM(스크립트) → 텍스트→비디오, (B) LALM(오디오를 직접 이해하는 오디오-언어 모델) → 이야기(스토리) → 장면 분해 → 텍스트→비디오.

- 결과는? 음악의 분위기·테마를 잘 포착하는 경우가 많지만, 장면 간 시각적 일관성(특히 등장인물 외형·화풍 유지) 이 약점으로 지적되었고, 소규모 사용자평가에서는 CLAP 기반이 약간 더 높은 점수를 받았어요.

- 한마디: 아이디어와 가능성은 뚜렷하지만, 비주얼 일관성·캐릭터 유지·대상 인물 품질(얼굴) 등에서 추가 연구가 필요합니다.

1) 한 줄 요약

음악을 ‘듣고’ 그것의 감정·리듬을 텍스트(장면 대본)로 옮긴 뒤, 그 텍스트로 비디오를 만들어 음악과 감정적으로 연동되는 뮤직비디오를 자동 생성하는 시도입니다.

2) 왜 이 연구가 흥미로운가?

기존 음악 비주얼라이저(스펙트럼 애니메이션 등)는 소리의 파형·주파수에 단순 반응하는 ‘무드등’ 수준이에요. 반면 이 연구는 음악이 전하는 이야기나 감정(예: ‘우울한 현악기’, ‘격렬한 드럼’)을 텍스트로 바꾸어 장면 중심의 스토리텔링 영상을 만들려는 점에서 차별됩니다. 가사 없는 연주곡도 ‘스토리’로 풀 수 있다는 게 포인트예요.

3) 핵심 아이디어

- 파이프라인 A (CLAP 기반)

- 곡을 여러 구간으로 자른다(편집자처럼).

- CLAP 모델로 각 구간의 특징(예: “현악 위주, 템포 빠름, 감정: 서정적”)을 뽑는다.

- LLM에 그 특징을 넣어 장면별 한 줄짜리 스크립트를 만든다.

- 각 장면 스크립트를 텍스트→비디오 모델(예: mochi-1)로 변환해 클립을 만들고 이어붙인다.

- 파이프라인 B (LALM 기반)

- 오디오를 직접 LALM(오디오-언어 모델)에 넣어 하나의 이야기(컨셉/스토리) 를 뽑는다.

- 그 스토리를 다시 장면들로 쪼개 대본을 만든 뒤 텍스트→비디오로 생성한다.

- 차이점: CLAP는 “음악을 태깅하는 친구 → 그 친구의 태그를 바탕으로 사람이 쓰는 대본” 같은 흐름이고, LALM은 “음악을 통째로 듣고 스스로 이야기(콘셉트)를 떠올리는 작가”에 가깝습니다.

4) 기술 구성요소

- CLAP: 음악을 듣고 “이 구간은 피아노·우울, 이 구간은 강한 드럼”처럼 라벨을 붙이는 도구 — 음악 태거(friend who tags sections).

- LALM: 음악 전체를 듣고 줄거리(“젊은 무용수의 성장기”)를 직접 써내는 작가형 모델.

- LLM(Reasoning LLM): CLAP의 라벨을 받아 장면별 짧은 대본으로 바꿔주는 시나리오 작가.

- 텍스트→비디오(디퓨전 모델): 장면 묘사를 받아서 실제 영상 프레임을 그려내는 ‘자동 영화 촬영팀’.

이 모든 단계의 중간 결과(스크립트·라벨)는 사람이 확인·수정하기 쉬운 텍스트로 남겨 투명성을 높였습니다.

5) 실험·평가 요약

- 소규모 예비평가: 5명의 비전문가가 각 파이프라인으로 만든 3편씩(총 6편)을 평가.

- 평가 항목: 스토리텔링, 시각 인상, 전환(씬 컷), 감정 일관성, 종합 인상 등.

- 결과(탐색적): CLAP 쪽 평균 점수가 약간 더 높음(전반적 인상 M=2.93 vs 2.64). 다만 표본이 작고 장르 배분도 통제되지 않아 예비 결과로 봐야 합니다.

6) 장점과 한계

- 장점 (왜 쓸 만한가?)

- 가사 없는 연주곡도 ‘이야기형’ 영상으로 만들 수 있다.

- 중간 결과(라벨·스크립트)가 텍스트라 편집자가 쉽게 개입해 스타일·톤을 바꿀 수 있다.

- 아티스트가 직접 ‘무드·색감·캐릭터 지침’을 넣어 창작을 보완할 수 있음.

- 한계 (현실적 문제)

- 시각적 일관성 부족: 장면마다 등장인물 얼굴·복장·화풍이 바뀌어 ‘영화 같은 연결성’이 떨어짐 — 즉, 주연 배우가 컷마다 다르게 생긴다. 예: 같은 주인공이 장면2에선 사람, 장면3에선 갑자기 동물로 나오는 경우가 보고됨.

- 프롬프트 민감성: 텍스트→비디오 모델은 한 문장 묘사에 매우 민감해서, 자동으로 생성된 문구가 미세하게 달라지면 결과가 확 달라짐.

- 얼굴·움직임 품질: 사람 얼굴·자연스러운 동작을 안정적으로 만들기 어려움(왜곡·불안정).

- 평가 한계: 사용자 평가는 소규모라 일반화 불가. 더 큰 사용자 연구와 비교 대상(프로 제작 영상) 필요.

7) 실무적 시사점

- 아티스트·인디 뮤지션: 빠르게 컨셉 영상을 만들어 시연용 데모·초안으로 활용하기 좋음(단, 최종 공개용은 사람 손질 권장).

- 크리에이티브 에이전시: 여러 아이디어를 저비용으로 실험해볼 수 있는 ‘아이디어 팩토리’로 유용.

- 연구자: 오디오→비주얼 멀티모달 연구의 좋은 출발점 — 특히 음악 특성 추출(감정·악기)과 후속 LLM 활용 연구에 기여.

8) 결론 & 다음 단계

음악의 감정과 구조를 텍스트로 해석해 자동으로 영상을 만드는 가능성은 분명하지만, 진짜 ‘뮤직비디오 수준’으로 가려면 장면·캐릭터의 시각적 일관성 강화, 얼굴·움직임 품질 향상, 그리고 대규모·통제된 사용자평가가 필요합니다.

댓글